データベースとの接続確立

安全かつ効率的なデータベース接続方法を学習する

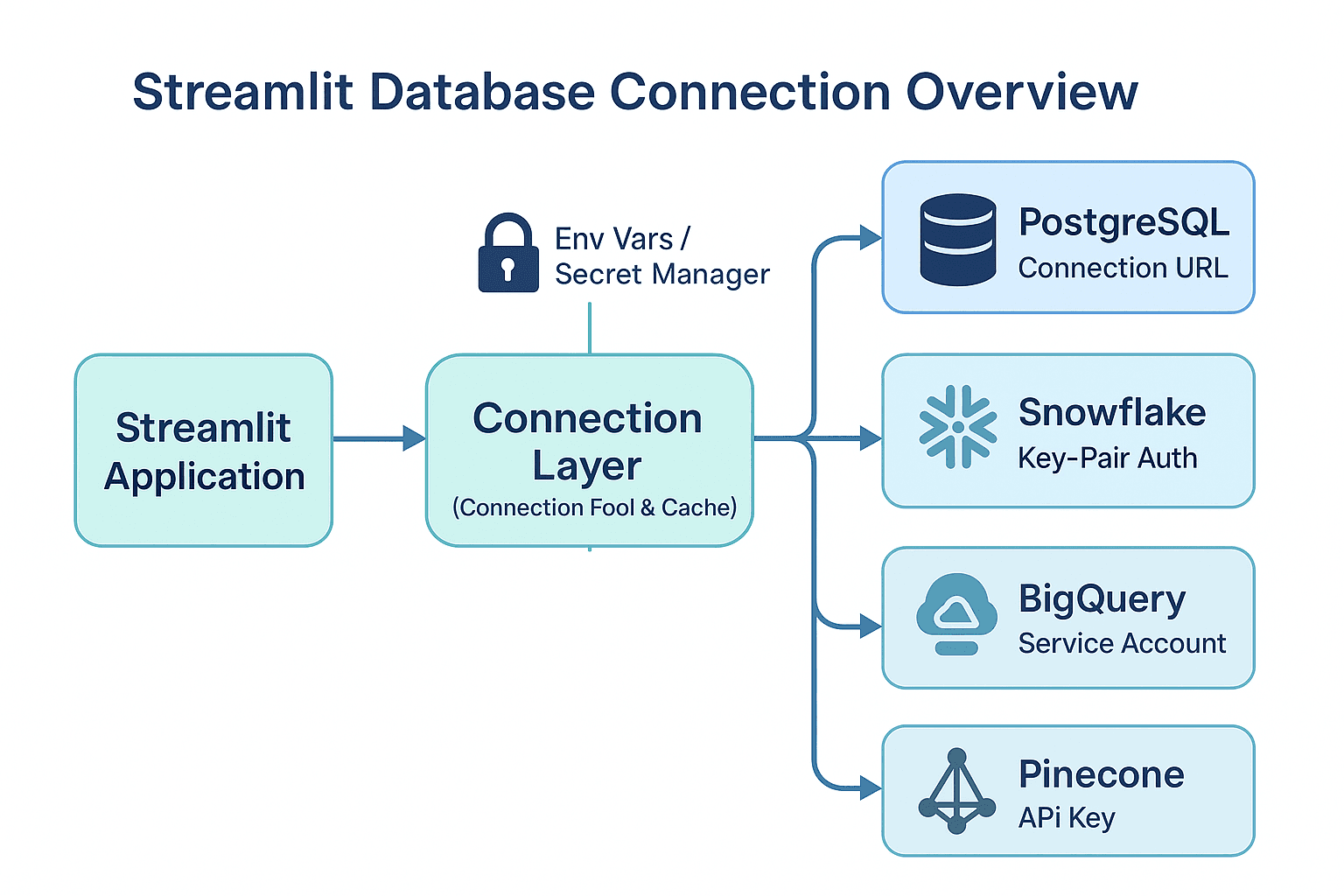

データの分析やダッシュボード作成において、データベースとの接続は欠かせません。この章では、安全かつ効率的な接続方法を学びます。

なぜデータベース接続が重要なのか

BIダッシュボードを作成する際、データは様々な場所に存在します。企業のデータウェアハウス、クラウドデータベース、さらには最新のベクトルデータベースまで、それぞれに適切な接続方法を理解することで、より柔軟で実用的なダッシュボードを構築できます。

Streamlitでは、接続プール(複数の接続を効率的に管理する仕組み)やキャッシュ機能を活用することで、高速で安定したデータアクセスを実現できます。

データベース接続の基本概念

接続プールとは

接続プール(Connection Pool)とは、データベースへの接続を事前に複数作成し、必要に応じて再利用する仕組みです。これにより、接続の作成コストを削減し、アプリケーションの性能を向上させることができます。

セキュリティの考慮事項

データベース接続では、認証情報(パスワードやAPIキー)の管理が重要です。これらの情報をコードに直接書き込むのは危険です。

避けるべき例:

# ❌ 危険:コードに直接パスワードを記述

password = "my_secret_password"推奨される方法:

# ✅ 安全:環境変数から取得

password = os.environ["DATABASE_PASSWORD"]主要データベースの特徴と適用場面

各データベースには異なる特徴があり、用途に応じて選択することが重要です。

主要データベースへの接続方法

PostgreSQL接続

PostgreSQLは、高機能なオープンソースのリレーショナルデータベースです。多くの企業で利用されており、Streamlitとの相性も良好です。

必要なパッケージ

sqlalchemy>=2.0

psycopg[binary]>=3.1

pandas>=2.2

dotenv>=1.0基本的な接続コード

import os

import streamlit as st

from sqlalchemy import create_engine, text

import pandas as pd

import dotenv

# Load environment variables from .env file

dotenv.load_dotenv()

@st.cache_resource(show_spinner="⏳ データベースに接続中...")

def get_engine():

db_url = os.environ["DATABASE_URL"]

engine = create_engine(

db_url,

pool_size=5,

pool_pre_ping=True

)

return engine

def get_data(sql):

engine = get_engine()

with engine.connect() as conn:

df = pd.read_sql(text(sql), conn)

return df

df = get_data("SELECT * FROM user LIMIT 1")

st.header("PostgreSQL Data Sample")

st.table(df)環境変数の設定例

-

DATABASE_URL=PostgreSQLの接続文字列

例:

postgresql://user:password@localhost:5432/mydatabase

ポイント

@st.cache_resourceを使用して接続を再利用pool_pre_ping=Trueで接続の健全性を自動チェック- 環境変数

DATABASE_URLで接続情報を管理

Snowflake接続

Snowflakeは、クラウドネイティブなデータウェアハウスサービスです。大量のデータを効率的に処理できるため、企業のBIシステムでよく利用されます。

必要なパッケージ

snowflake-connector-python

dotenv>=1.0秘密鍵認証の設定

Snowflakeでは、セキュリティを高めるため秘密鍵認証を使用することが推奨されます。詳細な設定方法については、Snowflake公式ドキュメントを参照してください。

Base64エンコードの方法:

macOS/Linux:

# 秘密鍵をBase64エンコード

base64 -i ~/.ssh/snowflake_rsa_key.p8 | tr -d '\n'Windows:

# 秘密鍵をBase64エンコード(PowerShell)

[Convert]::ToBase64String([System.IO.File]::ReadAllBytes("C:\path\to\snowflake_rsa_key.p8"))実装例(Snowflake接続):

# snowflake_connection.py

import base64

import os

from cryptography.hazmat.primitives import serialization

import snowflake.connector

import streamlit as st

import dotenv

# Load environment variables from .env file

dotenv.load_dotenv()

def get_snowflake_connection():

# 環境変数から秘密鍵を取得(Base64エンコードされたもの)

pem_bytes = base64.b64decode(os.environ["SNOWFLAKE_KEY_B64"])

private_key = serialization.load_pem_private_key(pem_bytes, password=None)

return snowflake.connector.connect(

user=os.environ["SNOWFLAKE_USER"],

account=os.environ["SNOWFLAKE_ACCOUNT"],

private_key=private_key,

warehouse=os.environ["SNOWFLAKE_WAREHOUSE"],

role=os.environ["SNOWFLAKE_ROLE"]

)

def execute_snowflake_query(sql):

conn = get_snowflake_connection()

cursor = conn.cursor()

cursor.execute(sql)

df = cursor.fetch_pandas_all()

cursor.close()

return df

df = execute_snowflake_query('SELECT * FROM PUBLIC."user" LIMIT 1')

st.header("Snowflake Connection Test")

st.table(df)環境変数の設定例

SNOWFLAKE_USER: ユーザー名SNOWFLAKE_ACCOUNT: アカウント識別子SNOWFLAKE_KEY_B64: Base64エンコードされた秘密鍵SNOWFLAKE_WAREHOUSE: 使用するウェアハウス名SNOWFLAKE_ROLE: 使用するロール名

BigQuery接続

BigQueryは、Googleの提供するクラウドデータウェアハウスサービスです。ペタバイト級のデータを高速で分析できます。

必要なパッケージ

google-cloud-bigquery[pandas]>=3.34.0

google-cloud-bigquery-storage>=2.32.0

dotenv>=1.0サービスアカウント認証

BigQueryでは、サービスアカウントのJSONファイルを使用して認証を行います。サービスアカウントの作成方法については、Google Cloud公式ドキュメントを参照してください。

JSONファイルのBase64エンコード方法:

macOS/Linux:

# サービスアカウントJSONをBase64エンコード

base64 -i service-account-key.json | tr -d '\n'Windows:

# サービスアカウントJSONをBase64エンコード(PowerShell)

[Convert]::ToBase64String([System.IO.File]::ReadAllBytes("C:\path\to\service-account-key.json"))実装例(BigQuery接続):

import base64

import json

import os

from google.oauth2 import service_account

from google.cloud import bigquery

def get_bigquery_client():

# 環境変数からサービスアカウントのJSON情報を取得

credentials_json = base64.b64decode(

os.environ['SERVICE_ACCOUNT_JSON_BASE64']

).decode('utf-8')

credentials_info = json.loads(credentials_json)

credentials = service_account.Credentials.from_service_account_info(

credentials_info

)

return bigquery.Client(credentials=credentials)

def query_bigquery(sql):

client = get_bigquery_client()

return client.query(sql).to_dataframe()環境変数の設定

SERVICE_ACCOUNT_JSON_BASE64: Base64エンコードされたサービスアカウントJSON

Pinecone接続(ベクトルデータベース)

Pineconeは、ベクトルデータベースサービスです。AI・機械学習の分野で、類似検索や推薦システムに利用されます。

必要なパッケージ

pinecone>=7.0.0

openai>=1.92.2

dotenv>=1.0基本的な接続方法

import os

import openai

import streamlit as st

from pinecone import Pinecone

from sentence_transformers import SentenceTransformer

import dotenv

# Load environment variables from .env file

dotenv.load_dotenv()

@st.cache_resource(show_spinner="🔄 Pineconeに接続中...")

def get_pinecone_index():

# Pineconeクライアントの初期化

pc = Pinecone(api_key=os.environ["PINECONE_API_KEY"])

index_name = os.environ.get("PINECONE_INDEX", "my-index")

# インデックスが存在しない場合は作成

if index_name not in pc.list_indexes().names():

pc.create_index(

name=index_name,

dimension=1536,

metric="cosine"

)

return pc.Index(index_name)

# 検索処理の例

def search_vectors(query_text):

index = get_pinecone_index()

res = openai.embeddings.create(

input=query_text,

model="text-embedding-ada-002"

)

query_vector = [r.embedding for r in res.data]

results = index.query(

vector=query_vector,

top_k=5,

include_metadata=True

)

return results

st.header("Pinecone Vector Search Example")

result = search_vectors("example query")

st.text(result)環境変数の設定

PINECONE_API_KEY: PineconeのAPIキーPINECONE_INDEX: 使用するインデックス名OPENAI_API_KEY: OPENAIのAPIキー

効率的なクエリ作成のコツ

データベースのパフォーマンスを最大化するためには、効率的なクエリの作成が重要です。

基本的な最適化手法

パフォーマンス向上のポイント

# ❌ 非効率な例

def get_all_users_then_filter():

df = get_data("SELECT * FROM users")

return df[df['status'] == 'active']

# ✅ 効率的な例

def get_active_users():

return get_data("""

SELECT user_id, name, email, created_at

FROM users

WHERE status = 'active'

LIMIT 1000

""")大量データの処理

大量のデータを扱う場合は、バッチ処理やページング処理を検討します。

def get_data_in_batches(table_name, batch_size=10000):

offset = 0

while True:

sql = f"""

SELECT id, name, created_at FROM {table_name}

ORDER BY id

LIMIT {batch_size} OFFSET {offset}

"""

batch_df = get_data(sql)

if len(batch_df) == 0:

break

yield batch_df

offset += batch_size接続設定の管理とトラブルシューティング

環境変数の設定方法

各データベースの認証情報は、環境変数として設定します。これにより、コードに秘密情報を含めることなく、安全に運用できます。

ローカル開発時:

export DATABASE_URL="postgresql://user:pass@localhost:5432/mydb"

export SNOWFLAKE_USER="myuser"

export SNOWFLAKE_ACCOUNT="myaccount"よくあるエラーと対処法

エラーハンドリングの実装

def safe_database_query(sql):

try:

return get_data(sql)

except Exception as e:

# ログに記録(実際のアプリケーションではロギングライブラリを使用)

print(f"データベースエラーが発生しました: {str(e)}")

return None

# 使用例

df = safe_database_query("SELECT * FROM users")

if df is not None:

# データが正常に取得できた場合の処理

return df

else:

# エラーが発生した場合の処理

return pd.DataFrame() # 空のDataFrameを返すパフォーマンス最適化のポイント

キャッシュの活用

Streamlitのキャッシュ機能を適切に使用することで、データベースへの負荷を軽減し、ユーザー体験を向上させることができます。

# 接続オブジェクトのキャッシュ

@st.cache_resource

def get_connection():

return create_connection()

# クエリ結果のキャッシュ

@st.cache_data(ttl=300) # 5分間キャッシュ

def get_user_data():

return query_database("SELECT * FROM users")接続プールの最適化

# PostgreSQLの例

engine = create_engine(

database_url,

pool_size=10, # 基本接続数

max_overflow=20, # 追加接続数

pool_timeout=30, # 接続待機時間

pool_recycle=3600 # 接続のリサイクル時間(秒)

)データ転送量の最適化

# 必要最小限のデータのみ取得

def get_dashboard_data():

return get_data("""

SELECT

DATE(created_at) as date,

COUNT(*) as user_count,

AVG(score) as avg_score

FROM users

WHERE created_at >= CURRENT_DATE - INTERVAL '30 days'

GROUP BY DATE(created_at)

ORDER BY date

""")まとめ

この章では、Streamlitアプリケーションから主要なデータベースに接続する方法を学びました。重要なポイントを整理します。

- 接続プールの活用 ...

@st.cache_resourceを使用して効率的な接続管理を行う - データベース選択 ... 用途に応じて適切なデータベースを選択する

- クエリ最適化 ... 必要なデータのみを効率的に取得する

- エラーハンドリング ... 適切な例外処理でユーザーフレンドリーなアプリケーションを作成する

- パフォーマンス最適化 ... キャッシュ機能を活用してレスポンス速度を向上させる

次のステップ

データベースとの接続が確立できたら、次の章でAIを活用したコード生成・編集について学びます。AIの力を借りて複雑なクエリや分析ロジックを簡単に作成できるようになります。

安全で効率的なデータベース接続が、高機能なBIダッシュボード構築の基盤となります。